近年来,研究人员开发了越来越多的计算技术,以使机器人具有类似人的能力。但是,到目前为止开发的大多数技术都只专注于人为地再现视觉和触觉,而忽略了诸如听觉感知之类的其他感觉。

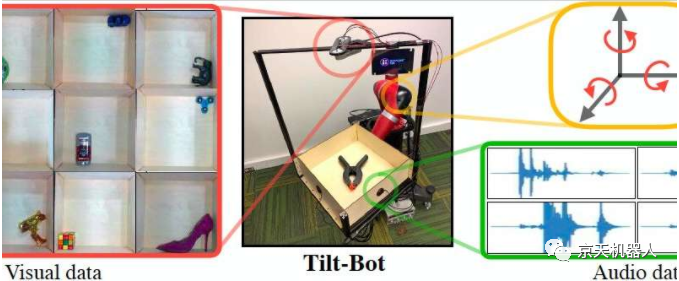

卡内基梅隆大学(CMU)的研究小组最近进行了一项研究,探讨了使用声音开发具有更先进传感功能的机器人的可能性。他们的论文发表在《Robotics: Science and Systems》上,介绍了迄今为止编译的最大的声音动作视觉数据集,该数据集是作为一个称为Tilt-Bot 的机器人平台(主体为瑞森可Sawyer 7自由度协作机械臂)收集的,并与各种各样的对象进行了交互。

“在机器人学习中,我们通常仅使用视觉输入进行感知,但是人类具有的感知方式不仅仅是视觉。”进行这项研究的研究人员之一Lerrel Pinto说。“声音是学习和理解我们的物理环境的关键组成部分。因此,我们提出了一个问题:机器人可以在声音判断上学我们吗?为回答这个问题,我们创建了Tilt-Bot,该机器人可以与物体互动并收集物体。互动的大规模视听数据集。”

本质上,Tilt-Bot是一个Sawyer+自动托盘组成的机器人平台,可以倾斜物体,直到它们碰到托盘的一面墙为止。Pinto和他的同事们在机械手托盘的墙壁上放置了接触式麦克风,以记录物体撞击墙壁时产生的声音,并使用高架摄像头直观地捕捉每个物体的运动。

研究人员收集了与60个不同对象进行的超过15,000次Tilt-Bot交互的视觉和音频数据。这使他们能够编译新的图像和音频数据集,这可以帮助训练机器人在动作,图像和声音之间建立关联。

Pinto和他的同事在论文中使用此数据集来探索机器人应用程序中声音与动作之间的关系,并收集了许多有趣的发现。首先,他们发现分析物体移动和撞击表面的声音记录可以使机器区分不同的物体,例如区分金属螺丝刀和金属扳手。

Pinto解释说:“我们研究的一个令人兴奋的初步结果是,仅凭声音,您就可以识别出接近80%的物体类型。” “我们还表明,机器可以学习基于音频的对象表示形式,从而在以后帮助解决机器人任务。例如,当识别空酒杯的声音时,机器人可以理解,对其进行操作将需要采取不同于操作的动作。它会在装满酒杯时发挥作用。”

有趣的是,录音有时可以比视觉表示提供更多有价值的信息来解决机器人任务,因为它们也可以用来有效预测物体的未来运动。在一系列使用机器人在训练过程中没有遇到过的物体的实验中,他们发现,当机器人与这些物体互动时收集的音频嵌入可以预测正向模型(即将来如何最好地操纵物体)提高24%而不是被动的视觉嵌入。

由这组研究人员汇编的数据集最终可以帮助开发机器人,这些机器人可以根据音频记录和在周围收集的图像来选择其动作和对象操纵策略。Pinto和他的同事现在正在计划进一步的研究,以探索声音分析在创建具有更高级功能的机器人方面的潜力。

Pinto说:“这项工作只是将声音整体集成到机器人技术中的第一步。” “在未来的工作中,我们将研究声音和动作的更实际的应用。”

参考文献:Gandhi D, Gupta A, Pinto L. Swoosh! Rattle! Thump!--Actions that Sound[J]. arXiv preprint arXiv:2007.01851, 2020.

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877