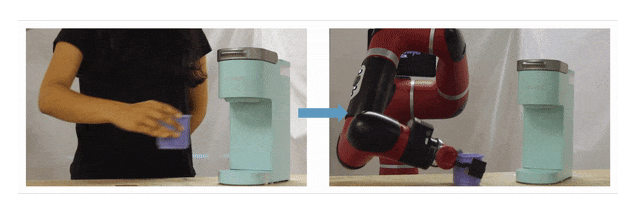

这项工作提出了AVID,一种允许机器人直接通过观看人的行为来学习任务(如煮咖啡)的方法

通过观察他人来学习的能力是智力水平的最重要标志之一。人类尤其擅长此事,通常能够通过观察其他人来学习任务。因为我们不只是复制他人采取的行动。相反,我们首先想象自己该如何执行任务。

机器人还不能通过观察人类或其他机器人来学习。机器人从任务演示中学习的模仿学习的现有方法通常假定可以使用诸如动作教学或远程操作等技术通过机器人直接进行演示。这种假设限制了机器人在现实世界中的适用性,在现实世界中,经常会要求机器人快速学习新任务,而无需程序员、机器人专家或专门的硬件设置。那么,我们可以让机器人直接从人类演示视频中学习吗?

这项工作提出了AVID,这是一种通过类似于人类的想象和实践策略从人类视频中进行机器人模仿学习的方法。给定人类演示视频,AVID首先通过图像到图像的翻译将这些演示转换为执行任务的机器人的视频。为了将人类视频直接在像素级别转换为机器人视频,我们使用了 CycleGAN,这是最近提出的模型,该模型可以使用来自每个域的未配对图像来学习两个域之间的图像到图像转换。

为了处理复杂的多阶段任务,我们从这些翻译的机器人演示中提取了指令图像,这些图像描述了任务的关键阶段。然后,这些指令为基于模型的强化学习(RL)程序定义了奖励功能,该功能使机器人可以练习任务以了解其执行情况。

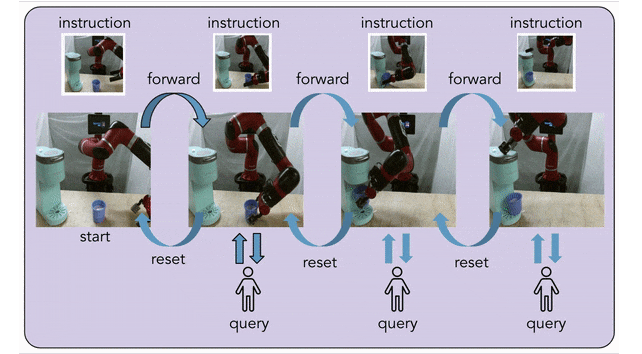

AVID的主要目标是最大程度地减少与定义任务和监督机器人相关的人员负担。通过人工视频提供奖励可处理任务定义,但是在实际学习过程中仍然存在人工成本。AVID通过让机器人学会自行重置任务的每个阶段来解决此问题,以便能够多次练习而无需人工干预。因此,机器人学习时所需的唯一人类参与就是按键和一些手动重置的形式。我们证明了这种方法能够以最少的人力参与来解决复杂的长期任务,消除了与检测任务设置,手动重置环境以及监督学习过程相关的大部分人力负担。

自动化的视觉指令-后续示范

AVID通过CycleGAN将人类指令图像转换为相应的机器人指令图像,并使用基于模型的RL学习如何完成每条指令

我们的方法称为automated visual instruction-following with demonstrations(AVID)。AVID依赖于图像到图像转换和基于模型的RL中的几个关键思想,在这里我们将讨论每个组件。

将人类视频翻译成机器人视频

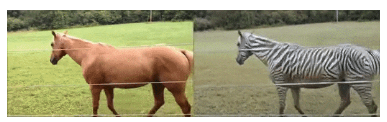

上:CycleGAN已成功完成了从马的视频到斑马的视频等任务。下:将CycleGAN应用于从人类演示视频到机器人演示视频的翻译任务

先前已证明CycleGAN在许多领域都有效,例如将马的视频逐帧转换为斑马。因此,我们训练了一个CycleGAN,其中的域是人类和机器人的图像:对于训练数据,我们收集了来自人类的演示以及来自人类和机器人的随机运动。这样,我们获得了一个CycleGAN,它能够从人类演示中生成伪造的机器人演示,如上所述。

尽管机器人演示大部分在视觉上都是逼真的,但翻译后的视频将不可避免地显示出伪影,例如咖啡杯取放和机器人夹具从手臂移开。这使得从完整视频中学习无效,因此我们设计了一种不依赖完整视频的替代策略。具体来说,我们 从翻译后的视频中提取说明该任务关键阶段的指令图像 。例如,对于上面显示的咖啡制作任务,指令包括抓取杯子,将杯子放入咖啡机中以及按一下按钮机器顶部。通过仅使用特定图像而不是整个视频,学习过程几乎不会受到翻译效果不佳的影响。

通过计划完成说明

我们从演示中提取的指令图像将整个任务分为几个阶段,AVID使用基于模型的计划算法来尝试并完成任务的每个阶段。具体来说,使用我们为CycleGAN训练收集的机器人数据以及翻译后的指令,我们将学习动力学模型以及一组指令分类器,这些分类器可预测何时成功完成每条指令。尝试阶段时 s,该算法对动作进行采样,使用动力学模型预测结果状态,然后选择分类器为阶段预测的动作 s拥有最大的成功机会。该算法在指定数量的时间步长内重复选择动作,或者直到分类器发出成功信号为止,即机器人认为机器人已经完成了当前阶段。

使用类似于SLAC模型的结构化潜在变量模型来学习基于图像观察和机器人动作的状态表示

先前的工作表明,训练结构化的潜在变量模型是学习基于图像的领域中任务的有效策略。在较高的层次上,我们希望我们的机器人从其视觉输入中提取状态表示,该状态表示是低维的,比直接从图像像素学习更容易学习。这是使用类似于SLAC模型的模型完成的,该模型引入了一个潜在状态,该状态被分解为两个部分,这些状态根据学习的动力学模型进行演化,并根据学习的神经网络解码器生成机器人图像。呈现图像观察结果后,机器人可以进行编码,图像通过另一个神经网络进入潜伏状态,并在状态级别而不是像素上运行。

通过基于模型的强化学习进行指导

AVID使用基于模型的计划来完成指令,当分类器发出成功信号时查询人员,并在未实现指令时自动重置。

通过让机器人自动尝试重置自身,我们减少了手动重置环境的人工负担,因为只有在杯子掉落等问题时才需要这样做。在大多数情况下,只需要人员在训练过程中提供按键,这比手动干预要简单得多且强度也不高。此外,逐级重置和重试允许机器人练习任务的困难阶段,从而集中学习过程并增强了机器人的行为。如下一节所示,AVID能够直接通过人类演示视频和最少的人工监督,在真正的Sawyer机器人手臂上解决复杂的多阶段任务。

实验

我们证明了AVID能够在真正的Sawyer机械手臂上学习多阶段任务,包括操作咖啡机和从抽屉中取出杯子

如上所述,我们在Sawyer机械臂上进行了实验,该机械臂是一个7自由度的机械手,它的任务是操作咖啡机并从封闭的抽屉中取出杯子。在这两个任务上,我们都将其与时差网络(TCN)进行了比较,后者是一种既可以从人类演示中学习机器人技能的现有方法。我们还烧蚀了我们的方法,以便从充分的示范中学习,我们将其称为“仿烧蚀”,并直接在像素级进行操作,我们将其称为“像素空间烧蚀”。最后,在我们可以直接通过机器人进行演示的环境中(这是大多数先前的模仿学习工作中所做的假设),我们将观察与行为克隆进行了比较(BCO)和标准的行为克隆方法。有关实验的其他详细信息,例如超参数和数据收集,请参阅本文。

任务设定

由人给出的指令图像(顶部),并转换到机器人的域(底部)中,用于咖啡制作(左)和杯子检索(右)任务。

如上所述,我们为咖啡制作任务指定了三个阶段。从左侧的初始状态开始,说明是拿起杯子,将杯子放入机器中,然后按机器顶部的按钮。我们为此目的总共使用了30个人类演示,总计约20分钟的时间。杯子检索是一项更为复杂的任务,我们在此处指定了五个阶段。从初始状态开始,说明是要抓住抽屉手柄,打开抽屉,向上移动臂并将其移开,抓住杯子并将杯子放在抽屉顶部。移动手臂的中间阶段很重要,这样机器人就不会碰到手柄并意外地合上抽屉,这突出了AVID的其他优势,因为指定这条附加说明就像在人类视频中细分另一个时间步一样简单。对于杯子的取回,我们使用了20个人类演示,再次总计约20分钟的人类时间。

结果

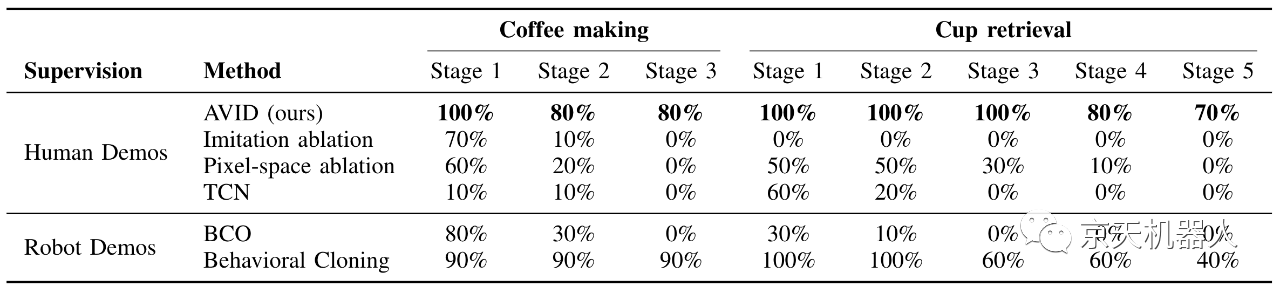

AVID明显优于在我们考虑的任务上使用人工演示的烧蚀和先前的方法。AVID与使用机器人本身给出的真实演示的基准方法相比甚至有时甚至胜过竞争对手

点击链接观看视频:https://mp.weixin.qq.com/s/ATvd-UUJyywyCfyDFpbGmg

上表和视频总结了运行AVID的结果以及咖啡制作和杯子检索任务的比较。AVID表现出出色的性能,并且大多数时间都成功地完成了两项任务的所有阶段,并且在开始阶段就具有了非常完美的性能。如视频所示,AVID在训练和最终评估过程中始终使用自动重置和重试功能,并且失败通常对应于较小但严重的错误,例如将杯子翻倒。与模仿或像素空间消融相比,AVID的性能也要好得多,这证明了通过分阶段训练和学习潜在变量模型获得的优势。最终,TCN可以学习检索的早期阶段,但否则通常不会成功。

我们还评估了两种方法,这些方法假定可以访问真实的机器人演示,而AVID则不需要。首先,BCO仅使用演示中的图像观察结果,并且此方法的性能在每个任务的后期阶段都会急剧下降。这突出了直接从完整的演示中学习临时扩展任务的困难。最后,我们将行为克隆与使用机器人观察和动作的行为进行比较,并注意到该方法是最强的基准,因为它使用了所有比较中最特权的信息。但是,我们发现AVID在检索方面仍胜过行为克隆,这很可能是由于AVID采用了明确的分阶段训练。

相关工作

如上所述,大多数关于模仿学习的工作 都假设可以直接在机器人上进行演示,而不是直接从人类视频中学习。但是,还通过各种方法(例如姿势和物体检测,预测模型,上下文 翻译,学习 奖励表示和元学习)研究了从人类视频中学习的方法 。这些方法与AVID之间的主要区别在于,AVID直接在像素级别上翻译人类演示视频,以便明确处理实施例中的更改。

此外,我们评估复杂的多阶段任务,而AVID解决这些任务的能力在一定程度上是通过结合明确的阶段式训练来实现的,其中每个阶段都会学习重置。RL中的先前工作还研究了 学习重置,类似地表明这样做可以学习多阶段任务,并减轻了人员负担,并减少了手动重置的需要。AVID结合了重置学习,图像到图像转换和基于模型的RL方面的思想,以便仅使用少量的人类演示就可以直接从现实世界中的图像观察中学习临时扩展的任务。

未来的工作

未来工作最激动人心的方向是扩展通用CycleGAN的功能,以便仅通过几个人类视频就可以高效学习各种各样的任务。想象一下一个CycleGAN,它在大型的厨房交互数据集上训练,其中包括咖啡机,多个抽屉和许多其他对象。如果CycleGAN能够可靠地翻译涉及这些对象中任何一个的人类演示,那么这就打开了通用厨房机器人的可能性,该机器人可以通过观察和少量练习即可快速执行任何任务。开展这一研究领域是使有能力且有用的机器人能够通过观察人类真正学习的有前途的途径。

这篇文章基于以下论文:

Smith L, Dhawan N, Zhang M, et al. AVID: Learning Multi-Stage Tasks via Pixel-Level Translation of Human Videos[J]. arXiv preprint arXiv:1912.04443, 2019.

需要获取原文,可以关注微信公众号留言。

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877