陆军研究人员开发了一种强化学习方法,该方法将使无人驾驶的空中和地面车辆成群地最佳完成各种任务,同时最大程度地降低性能不确定性。

分组是一种操作方法,其中多个自治系统通过主动协调其动作来充当凝聚单元。

陆军研究人员说,未来的多领域战斗将需要成群的动态耦合,协调的异构移动平台来与敌方能力和针对美军的威胁相提并论。

美国陆军作战能力发展司令部陆军研究实验室的杰明·乔治博士说,陆军正在寻求采用技术来执行耗时或危险的任务。

乔治说:“实时为这些拥挤的车辆找到最佳的制导策略,是增强战士的战术态势意识,使美军在竞争激烈的环境中独占a头的关键要求。”

增强学习提供了一种方法,可以在无法使用精确的模型时,最优地控制不确定的代理,以实现多目标目标。然而,现有的强化学习方案只能以集中方式应用,这需要将整个群体的状态信息集中在中央学习者处。乔治说,这大大增加了计算复杂性和通信要求,导致学习时间不合理。

为了解决这个问题,乔治与北卡罗来纳州立大学的Aranya Chakrabortty教授和俄克拉荷马州立大学的He Bai教授合作,致力于解决大规模的多主体强化学习问题。陆军通过外部合作计划主任研究奖为这项工作提供了资金,该计划是一项实验室计划,旨在与外部合作伙伴合作来激发和支持新的创新研究。

这项工作的主要目标是为大规模群体网络的数据驱动的最优控制开发理论基础,在该模型中,控制动作将基于低维测量数据而不是动态模型进行。

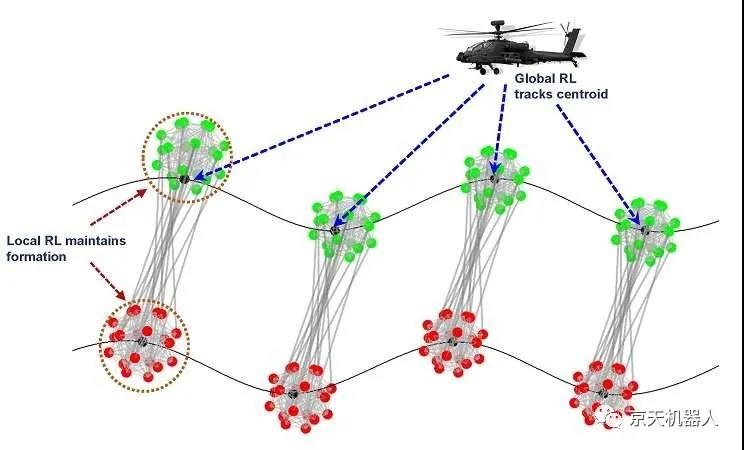

当前的方法称为“层次强化学习”(HRL),它将全局控制目标分解为多个层次结构,即多个小组级别的微观控制和广泛的群体层次的宏观控制。

乔治说:“每个等级都有自己的学习循环,分别具有本地和全球奖励功能。” “通过并行运行这些学习循环,我们能够大大减少学习时间。”

陆军研究人员设想了用于地面飞行器和空中飞行器协调的分级控制

根据George的说法,群体的在线强化学习控制归结为使用系统或群体输入/输出数据来求解大规模代数矩阵Riccati方程。

研究人员解决此大规模矩阵Riccati方程的最初方法是将群体分为多个较小的组,并并行执行组级局部增强学习,同时在每个组的较小尺寸压缩状态下执行全局增强学习。

他们当前的HRL方案使用了一种消散机制,该机制允许团队首先解决局部强化学习问题,然后从局部控制器合成全局控制(通过解决最小二乘问题),从而对大型矩阵方程进行分层近似求解。在汇总状态下进行全局强化学习的过程。这进一步减少了学习时间。

实验表明,与集中式方法相比,HRL可以将学习时间减少80%,同时将最佳损失限制为5%。

乔治说:“我们目前在人力资源管理方面所做的努力将使我们能够为无人驾驶的航空和地面车辆群制定控制政策,从而使他们能够最佳地完成不同的任务集,即使这些成群的特工的个人动力尚不清楚。”

乔治表示,他相信这项研究将对未来的战场产生影响,并且已经通过进行创新的合作而成为可能。

乔治说:“ ARL科学和技术社区的核心目的是创造和利用科学知识来实现转型的过度竞争。” “通过通过ECI和其他合作机制进行外部研究,我们希望进行破坏性的基础研究,这将导致陆军现代化,同时成为陆军与全世界科学界的主要合作纽带。”

该团队目前正在努力通过考虑群体中智能体的最佳分组来进一步优化其HRL控制方案,以最大程度地减少计算和通信复杂性,同时限制最优间隙。

他们还研究使用深度递归神经网络来学习和预测最佳分组模式,以及在稠密的城市地形中的多域作战中,对先进的空中和地面车辆进行最佳协调的发达技术的应用。

乔治与ECI合作伙伴最近在2020年美国控制会议上组织并主持了有关多代理强化学习的受邀虚拟会议,他们在会议上介绍了他们的研究结果。

原文:Bai H, George J, Chakrabortty A. Hierarchical control of multi-agent systems using online reinforcement learning[C]//2020 American Control Conference (ACC). IEEE, 2020: 340-345.

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877