机器人和人工智能(AI)的发展为开发能够适应动态环境的先进、复杂的辅助机器人打开了大门。这些机器人不仅可以提供个性化的帮助,还可以从互动中学习。辅助机器人现在可以设计为支持残疾人或其他有限制的人进行日常活动,并可以提高独立性、机动性和整体生活质量。

开发辅助机器人是一个具有挑战性的研究领域,尤其是当将这些系统集成到家庭和医院等人类环境中时。为了应对这些挑战,圣克拉拉大学的人机交互与创新(HMI2)实验室正在开发一种多功能智能机器人。

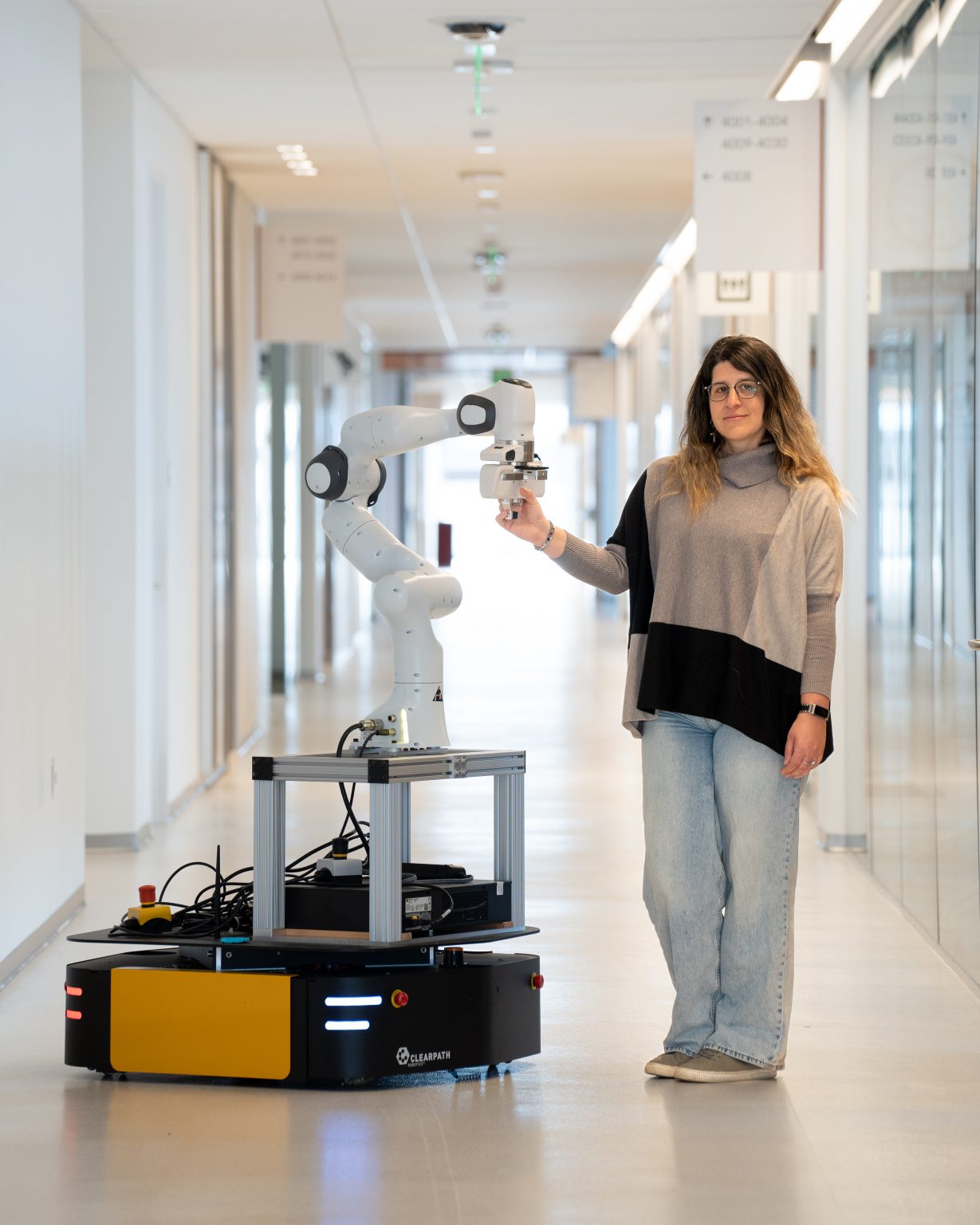

这款名为“Alex”的辅助机器人由Clearpath Robotics的多功能室内全向平台Ridgeback组成。Ridgeback使用其全方位驱动装置轻松移动机械手和重型有效载荷。在这种情况下,Ridgeback移动机器人的顶部安装了一个Franka臂,用于在医院等拥挤环境中引导人们。此外,该系统包括两个摄像头。Intel D405相机安装在机械臂的末端执行器上,用于识别环境中的物体和改进抓握点。第二个摄像头是Intel D455摄像头,安装在移动底座上,用于识别环境中的物体并改进导航。

截至目前,该团队已经在两个非常不同但同样动态的环境中测试了机器人,以展示机器人的多功能性。他们专注于两项主要任务:

(1) 在医院等拥挤区域提供步行辅助。

(2) 与人协作烹饪

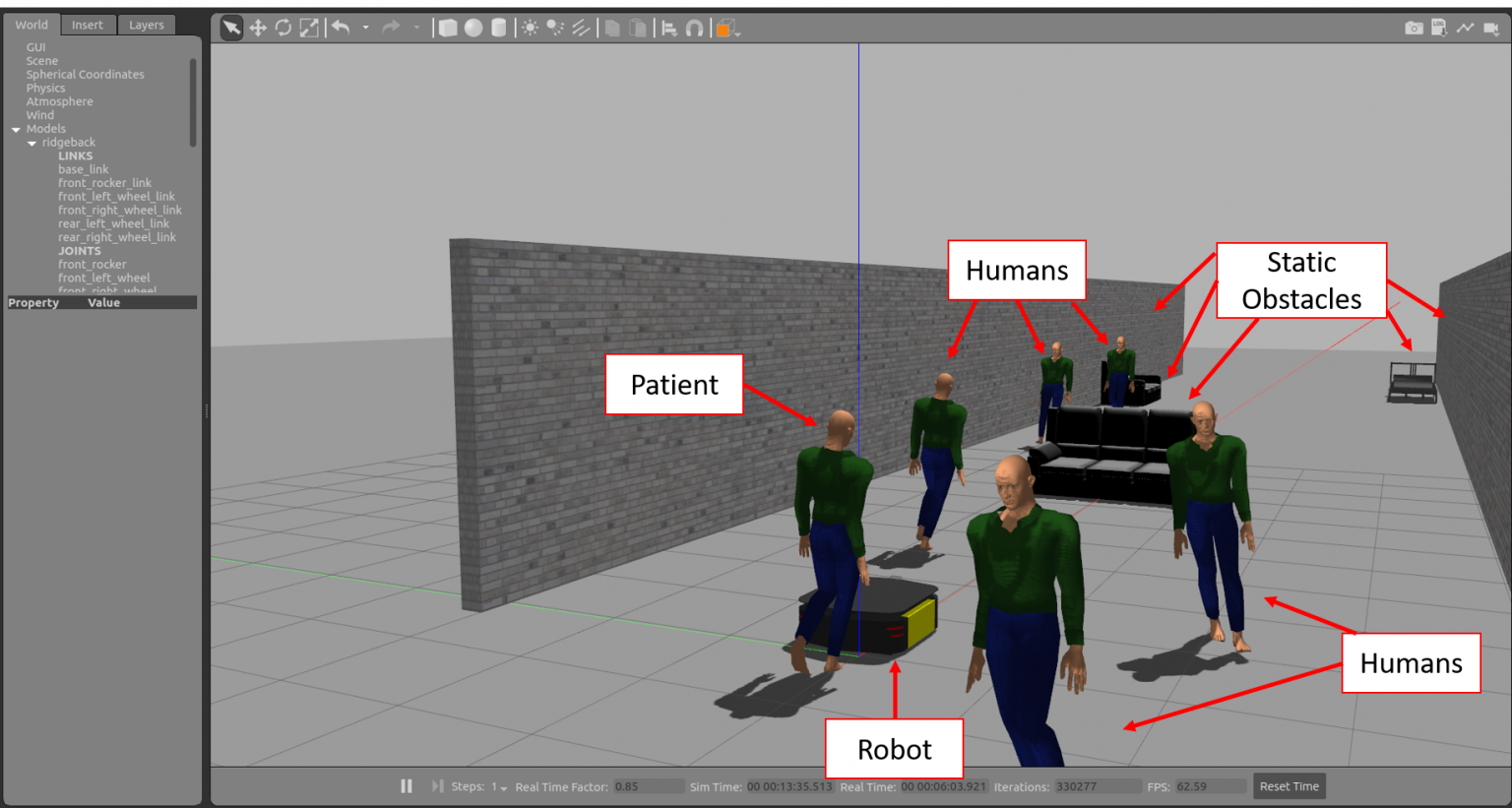

在第一项任务中,Alex熟练地引导患者穿过医院拥挤的走廊,避免发生碰撞。为了完成这项任务,团队使用深度强化学习开发了一个复杂的框架。该框架有助于患者和机器人之间的协同导航,同时实现静态和动态避障。该框架在Gazebo进行了评估和实施。该框架和环境都建立在开源的机器人操作系统(ROS)之上。

在第二项任务中,Alex展示了理解人类语音指令并获取协作烹饪所需物品的能力。口语互动是人类与同伴交流的一种自然方式。随着ChatGPT在自然语言处理(NLP)方面的最新突破,人类和机器人现在可以在自然、非结构化的对话中进行通信。利用这些工具,该团队引入了一个名为Speech2Action的框架,该框架使用口语作为输入,并根据烹饪任务的口语指令自动生成机器人动作。

以下是Alex在协作烹饪任务中获取的一些烹饪项目:

该团队对30名参与者进行了一项研究,以评估他们的框架。参与者在协作烹饪任务中完成了结构化和非结构化命令。这项研究表明,机器人的错误如何影响我们对其效用的感知,以及它们如何塑造我们对这些互动的整体观点。最终结果显示,与预期相反,大多数参与者倾向于无脚本叙事,倾向于机器人参与自发对话和有意义的对话。这促进了人类和机器人之间更人性化和适应性更强的交流。

这些任务的成功实施不仅证明了机器人的多功能性,而且为人机交互和辅助机器人领域的新可能性铺平了道路。

团队选择Ridgeback是因为它的可靠性和Clearpath广泛的ROS支持。

“Clearpath的机器人系统非常可靠。我们已经进行了40多个小时的用户研究,Ridgeback非常出色。ROS支持也非常有帮助,因为我们可以非常快速可靠地部署我们的框架。”-圣克拉拉大学电气和计算机工程系助理教授Maria Kyrarini博士

该团队计划将他们的框架扩展到其他任务,如机器人协助做好工作准备。此外,他们有兴趣为盲人或视障人士开发解决方案。他们计划与最终用户一起评估他们的系统,因为开发包容性机器人对团队来说很重要。

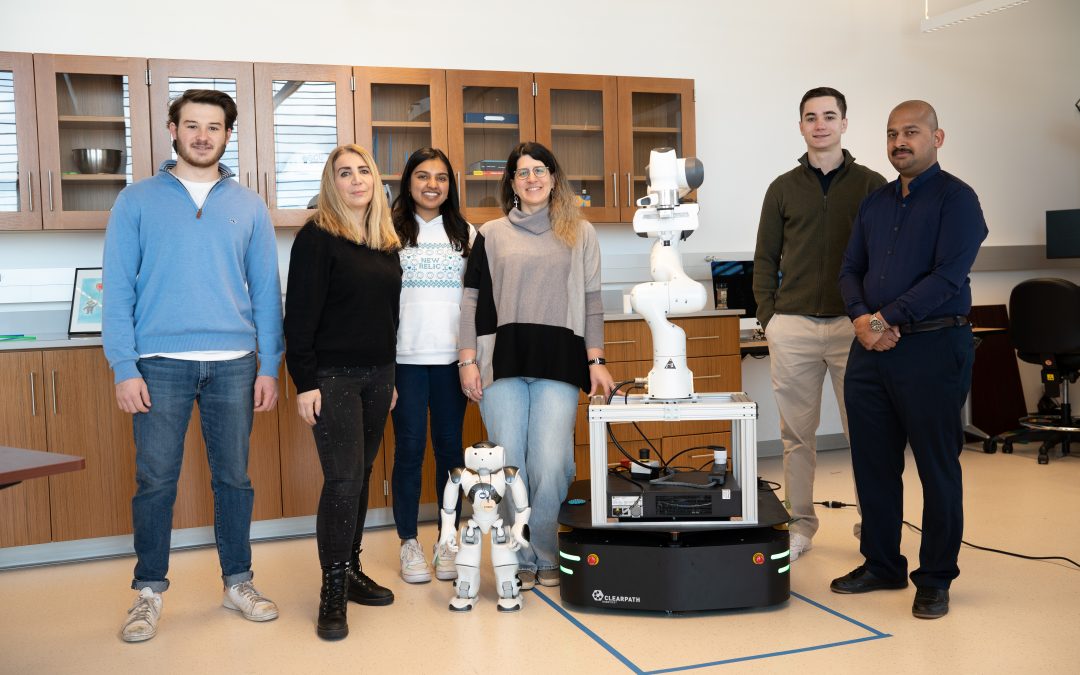

参与该项目的团队成员包括Maria Kyrarini(助理教授)、Krishna Kodur(博士生)、Mazizeh Zand(博士生生)、Aly Khater(硕士生)、Sofia Nedorosleva(硕士学生)、Matthew Tognotti(本科生)、Aidan O'Hare(本科生)和Julia Lang(大学生)。

如果你想了解更多关于人机交互与创新(HMI2)的信息,你可以访问他们的LinkedIn页面。https://www.linkedin.cn/incareer/company/human-machine-interaction-and-innovation-lab-hmi-2/

[1] Kodur K., Kyrarini M., 2023. Patient–Robot Co-Navigation of Crowded Hospital Environments. Applied Science 2023, 13(7), 4576.

https://www.mdpi.com/2076-3417/13/7/4576

[2] Kodur K., Zand M., and Kyrarini M., 2023. Towards Robot Learning from Spoken Language. In Companion of the 2023 ACM/IEEE International Conference on Human-Robot Interaction (HRI ’23 Companion), pp. 112-116. ACM.

https://dl.acm.org/doi/10.1145/3568294.3580053

[3] Zand M., Kodur K., and Kyrarini M., 2023. Automatic Generation of Robot Actions for Collaborative Tasks from Speech. 2023 9th International Conference on Automation, Robotics and Applications (ICARA), pp. 155-159. IEEE.

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10125800

[4] Krishna Kodur, Manizheh Zand, Matthew Tognotti, Cinthya Jauregui, and Maria Kyrarini. Structured and Unstructured Speech2Action Frameworks for Human-Robot Collaboration: A User Study. TechRxiv. August 28, 2023. [under review]

https://www.techrxiv.org/doi/full/10.36227/techrxiv.24022452.v1

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877

Donghu Robot Laboratory, 2nd Floor, Baogu Innovation and Entrepreneurship Center,Wuhan City,Hubei Province,China

Tel:027-87522899,027-87522877